SEO Workshop: Sitemap

Goede websites zijn gemakkelijk te crawlen.

Zoekmachines gebruiken de sitemap om efficiënter te crawlen doorheen je website.

De crawler kan daardoor sneller bepaalde pagina’s terugvinden.

De sitemap bevat informatie over:

- Hoeveel pagina’s de website heeft

- Prioriteit van de pagina’s

- Wanneer laatst aangepast

- Het aantal afbeeldingen

- Hoeveel posts de website bevat, de categorieën van de posts, de tags

- In het geval van een webshop: de producten en de productcategorieën

De sitemap is een supplement om makkelijker (efficiënter) te crawlen. Het heeft geen invloed op de manier waarop pagina’s geranked worden. Je kan dus niet aangeven “rank deze pagina beter dan die pagina”.

Wat doet de sitemap?

De sitemap laat de crawler efficiënter werken waardoor we minder “crawl budget” verbruiken en waardoor eventueel meer pagina’s geïndexeerd en gecrawled kunnen worden.

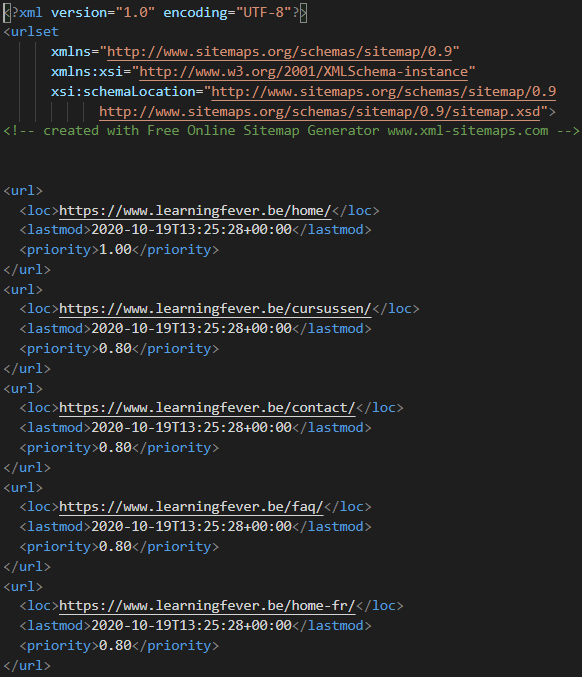

De sitemap is een publiek toegankelijk bestand dat standaard in xml (extensible markup language) formaat wordt opgeslagen. Xml kan je gewoon lezen als je die bekijkt, maar eigenlijk is xml bedoeld om machines te helpen data te lezen en te begrijpen. -> de crawlerbots

Een sitemap kan je zelf maken, laten genereren of met een plugin maken. In WordPress gebruik ik zelf Yoast Seo hiervoor. Er zijn er nog andere: xml sitemaps, xml sitemap & google news …

De sitemap van Learningfever kan je hier vinden.

User Sitemap vs XML Sitemap

We maken soms onderscheid tussen een user sitemap die aan de gebruiker een overzicht geeft van de meest relevante webpagina’s en informatie. Deze is geschreven voor mensen en is niet in xml.

Soms worden delen van de sitemap ook vermeld in een SEO footer.

| User SiteMap | XML SiteMap |

| Gestructureerde HTML versie van de website structuur met URLs | Alle URLs met relevante meta informatie (laatst aangepast, belangrijkheid, …) |

| Overzicht pagina’s en informatie | Kan je meegeven aan zoekmachines voor indexering |

| Geschreven voor mensen | Geschreven voor spiders |

SEO Footer is een kleine user sitemap die google helpt om te crawlen. Deze staat namelijk onderaan (in de footer) van de belangrijkste pagina’s vermeld met hyperlinks naar de meest relevante pagina’s.

In de Footer komen de belangrijkste product- of dienstenpagina’s terug. Hier heeft de bezoeker iets aan en bovendien draagt het bij aan de websitestructuur, wat dan weer goed is voor onze SEO.

Door de belangrijkste pagina’s, ofwel de pagina’s waar je op gevonden wilt worden, ook in je Footer te plaatsen krijgen deze de meeste interne links, vermits de Footer op iedere pagina terugkomt. De belangrijkste categorieën krijgen zo links vanaf elke pagina. Zoekmachines zien deze pagina’s vervolgens als belangrijk.

Bemerk dat de homepage van je website een van de krachtigste pagina‘s is voor SEO. Meestal komt de spider hier binnen en worden de belangrijkste pagina’s hierlangs gecrawled. De spider kan natuurlijk ook via een link op een publiek forum of blog binnenkomen of via sociale media.

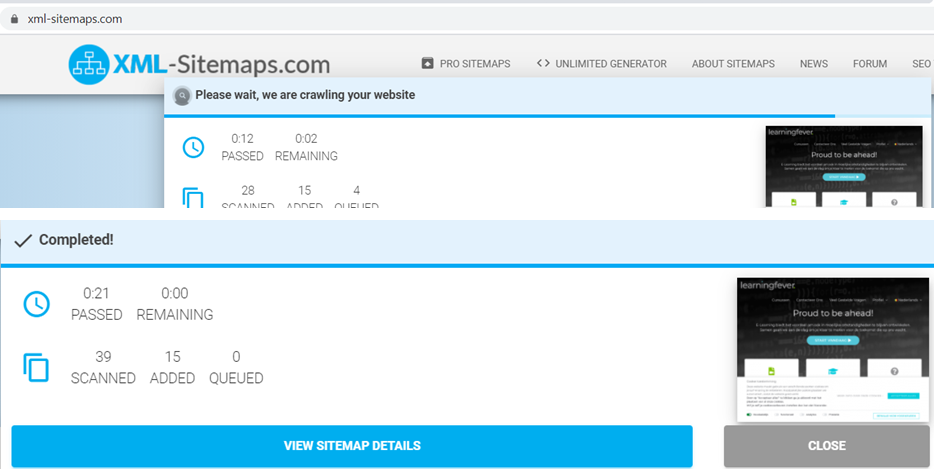

Er zijn sitemap generator websites zoals bijvoorbeeld: xml-sitemaps.com. Indien je zelf een sitemap maakt of met een generator ga je die moeten uploaden via ftp (Filezilla) naar de root van je website. De map waar je inlogt via ftp.

Sitemap Genereren

We kunnen met deze tool onze sitemap automatisch laten genereren.

Jullie mogen allemaal eens een sitemap genereren. Je kan kiezen om die te genereren van je eigen website of een website die je gemaakt hebt voor iemand of de de website van Multimedi. -> https://www.multimedi.be

Typisch heeft de sitemap de naam “sitemap.xml” maar andere namen zijn ook toegestaan.

We hebben vier vereisten

- opdeling per taal (aparte sitemap.xml per taal)

- subcategorisaties (we maken aparte sitemappen aan voor subcategorieën, bvb op grote e-commerce websites)

- maximaal 50.000 URLs samen in één sitemap (anders updelen in verschillende sitemaps)

- robots.txt vermeldt de sitemap locatie ((en diens naam indien aangepast))

We plaatsen de sitemap.xml in de root directory van de website. Hiermee kunnen spiders onze site efficienter crawlen. Het geeft aan wanneer de laatste update gebeurde, welke pagina’s voor ons het belangrijkste zijn en welke URLs gecrawled mogen worden.

De sitemap ziet er als volgt uit:

Soms wordt de sitemap wat “verstopt” zoals bij twitter maar deze is uiteindelijk wel vindbaar.

Hou er rekening mee als je die zelf maakt of via een generator dat die niet dynamisch zijn, met een plugin wel. Dat wil zeggen dat er geen nieuwe toevoegingen automatisch bijkomen als je nieuwe pagina’s of posts maakt.